Unterschied zwischen MapReduce und Funken

- 2838

- 250

- Fr. Fine Zschunke

Apache Spark ist eines der aktivsten Open-Source-Projekte im Hadoop-Ökosystem und eine der heißesten Technologien in der Big Data-Analyse heute. Sowohl MapReduce als auch Spark sind Open -Source -Frameworks für die Big -Data -Verarbeitung. Spark ist jedoch für die Verarbeitung von In-Memory-Verarbeitung bekannt und ideal für Fälle, in denen Daten in den Speicher passt, insbesondere bei speziellen Clustern. Wir vergleichen die beiden führenden Software -Frameworks, um zu entscheiden, welches für Sie das Richtige für Sie ist.

Was ist Hadoop MapReduce?

MapReduce ist ein Programmiermodell innerhalb des Hadoop -Frameworks für verteiltes Computing basierend auf Java. Es wird verwendet, um im Hadoop -Dateisystem (HDFS) auf Big Data zugreifen zu können. Es ist eine Möglichkeit, Ihre Berechnung zu strukturieren, mit der sie auf vielen Maschinen problemlos ausgeführt werden können. Es ermöglicht eine massive Skalierbarkeit über Hunderte oder Tausende von Servern in einem Hadoop -Cluster. Es ermöglicht das Schreiben verteilter, skalierbarer Jobs mit wenig Aufwand. Es dient zwei wesentliche Funktionen: Es filtert und verteilt die Arbeit an verschiedene Knoten innerhalb des Clusters oder der Karte. Es wird für die Datenanalyse in großem Maßstab unter Verwendung mehrerer Maschinen im Cluster verwendet. Ein MapReduce-Framework ist in der Regel ein dreistufiger Prozess: Karte, mischen und reduzieren.

Was ist Apache Spark?

Spark ist eine Open -Source -Framework von Super Fast Big Data, die als Nachfolger des MapReduce -Frameworks zur Verarbeitung von Big Data allgemein angesehen wurde. Spark ist eine Hadoop -Verbesserung zu MapReduce, die für Big Data Workloads verwendet wird. Für eine Organisation, die über eine massive Datenmenge zur Analyse verfügt. Es handelt sich. Das einheitliche Programmiermodell macht es zur besten Wahl für Entwickler, die datenreiche analytische Anwendungen erstellen. Es begann 2009 als Forschungsprojekt an der UC Berkleys Amplab, als gemeinsame Anstrengungen, an denen Studenten, Forscher und Fakultäten beteiligt sind.

Unterschied zwischen MapReduce und Funken

Datenverarbeitung

- Hadoop verarbeitet Daten in Stapeln und MapReduce arbeitet in sequentiellen Schritten, indem Daten aus dem Cluster gelesen und ihre Vorgänge auf den Daten ausgeführt werden. Die Ergebnisse werden dann an den Cluster zurückgeschrieben. Es ist eine effektive Methode, um große, statische Datensätze zu verarbeiten. Spark hingegen ist eine allgemeine verteilte Datenverarbeitungsmaschine, die Daten parallel über einen Cluster verarbeitet. Es führt Echtzeit- und Graph-Verarbeitung von Daten durch.

Leistung

- Hadoop MapReduce ist relativ langsamer, da es Operationen auf der Festplatte ausführt und keine nahezu Echtzeitanalysen aus den Daten liefern kann. Spark hingegen ist so konzipiert, dass er Daten in Memory und nicht in der Scheiben-E/A verändert, was sich wiederum um die Verarbeitungszeit verkürzt,. Spark ist tatsächlich 100-mal schneller und zehnmal schneller auf der Festplatte. Im Gegensatz zu MapReduce kann es mit der Echtzeitverarbeitung umgehen.

Kosten

- Hadoop läuft zu geringeren Kosten, da es sich. Spark erfordert mehr RAM, was bedeutet. Darüber hinaus ist Spark relativ neu, daher sind Experten für Spark seltene Funde und teurer.

Fehlertoleranz

- MapReduce ist streng diskbasierte Mittel, die anhaltend Speicher verwendet werden. Während beide ein gewisses Maß an Handhabungsfehlern liefern, basiert die Fehlertoleranz von Funken hauptsächlich auf seinen RDD -Operationen (Resilient Distributed Datasets). RDD ist der Baustein von Apache Spark. Hadoop ist natürlich tolerant, da es so konzipiert ist.

Benutzerfreundlichkeit

- MapReduce hat keinen interaktiven Modus und ist ziemlich komplex. Es muss APIs mit niedrigem Niveau verarbeiten, um die Daten zu verarbeiten, für die viel Codierung erforderlich ist, und die Codierung erfordert die Kenntnis der beteiligten Datenstrukturen. Der Spark wird von unten nach oben für Leistung und Benutzerfreundlichkeit ausgeht, was aus seinem allgemeinen Programmiermodell stammt. Auch die parallelen Programme sehen auf den sequentiellen Programmen sehr ähnlich und erleichtern sie einfacher zu entwickeln.

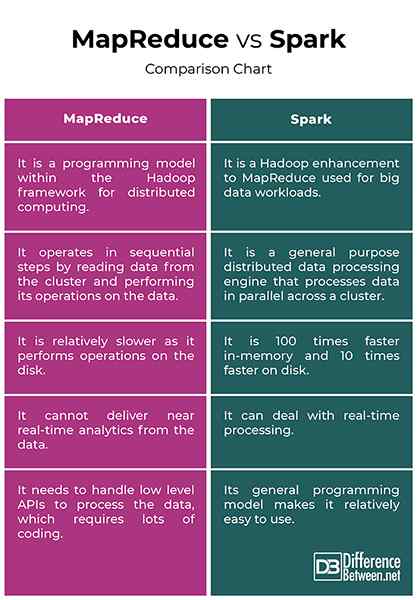

MapReduce vs. Spark: Vergleichstabelle

Zusammenfassung

Der Hauptunterschied zwischen den beiden Frameworks besteht darin, dass MapReduce Daten auf der Festplatte verarbeitet. Infolgedessen ist Spark 100-mal schneller und zehnmal schneller auf der Festplatte als MapReduce. Hadoop verwendet den MapReduce, um Daten zu verarbeiten, während Spark widerstandsfähige verteilte Datensätze (RDDs) verwendet. Spark ist eine Hadoop -Verbesserung von MapReduce zur Verarbeitung von Big Data. Während MapReduce immer noch für die Datenanalyse in großem Maßstab verwendet wird, ist Spark zum Verarbeitungsrahmen in Hadoop-Umgebungen geworden.

Warum Spark schneller als MapReduce ist?

Funkenprozesse und behalten Daten im Speicher für nachfolgende Schritte, wodurch es 100 -mal schneller für Daten in RAM und bis zu 10 -mal schneller für Daten im Speicher ist. Die RDDs ermöglichen mehrere Kartenvorgänge im Speicher, während MapReduce Zwischenergebnisse auf eine Festplatte schreiben muss.

Was sind die Unterschiede zwischen Spark- und MapReduce -Namen mindestens zwei Punkte?

Erstens kann MapReduce keine nahezu Echtzeitanalysen aus den Daten liefern, während Spark mit der Echtzeitverarbeitung von Daten umgehen kann. Zweitens arbeitet MapReduce in sequentiellen Schritten, während Spark Daten parallel über einen Cluster verarbeitet.

Ist Spark fortgeschrittener als MapReduce?

Spark wird allgemein als Nachfolger des MapReduce -Frameworks zur Verarbeitung von Big Data angesehen. Tatsächlich ist Spark eines der aktivsten Open-Source-Projekte im Hadoop-Ökosystem und eines der heißesten Technologien in der Big Data-Analyse heute.

Benötigt Funken MapReduce??

Spark verwendet oder benötigt MapReduce nicht, sondern nur die Idee davon und nicht die genaue Implementierung.

- « Unterschied zwischen maschinellem Lernen und Varianz

- Unterschied zwischen Masthead und Fractional Rig »